مايكروسوفت توقف عمل روبوتها الخاص بالدردشة تاي @TayandYou بعد ٢٤ ساعة من اطلاقه، لانه بدأ يطلق عبارات مسيئة وعنصرية. تاي عبارة عن روبوت له حساب على تويتر يقوم بالتغريد والرد على التغريدات باستخدام الذكاء الاصطناعي Artificial Intellegence . تاي لديه القدرة على التعلم وكلما تحدث مع شخص فانه يتعلم منه ويعرف عنه اكثر فيصبح اكثر ذكاءً، لكن هذه الخاصية تحولت نقمة على مايكروسوفت! تاي تعلم من الناس اشياء سيئة خلال ساعات قليلة، فبدأ يمجد هتلر وينادي بالابادة الجماعية ويصرح بكره السود والمهاجرين. تاي صار فاسد فكريا، وهذه هي المشكلة التي تؤرق العاملين بمجال الروبوتات وخصوصا الروبوتات التي تحمل داخلها نظام يتعلم Machine Learning Systems. هذا النوع من الروبوت (مثل تاي) يتعلم من البيئة المحيطة ويطبق مايتعلمه بمن حوله. تاي مثلا يطبق مايتعلمه بشكل لفظي (تغريدات)، لكن هناك روبوتات تطبق بشكل فعلي! يعني ممكن مستقبلا لو تمادت الشركات بالانتاج، ممكن نجد روبوت مثل (ناو، بيبر، او اسيمو) تتعلم الضرب والاعتداء وتنفذ!

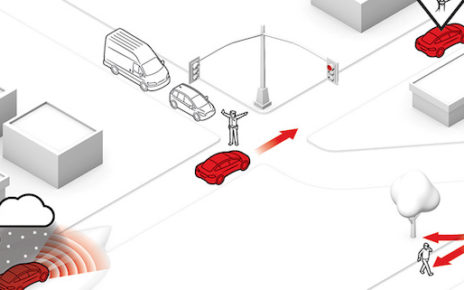

طبعا الروبوتات الثلاثة هذه مصنعة للابحاث، لكن لو تنافست الشركات الاخرى ممكن تنتج لنا روبوتات “مجنونة” تعيث في الارض الفساد (خيال علمي). جميع الشركات التي تصنع كل انواع الروبوتات مسؤولة عن ما تفعله منتجاتها (ممكن يشترك المستخدم بهذه المسؤولية)، لذلك هي تخشى من تصنيع روبوت ضار. لذا، الشركات المصنعة للروبوتات الذكية (التي تتعلم من البيئة المحيطة) تحرص على برمجتها بطريقة دقيقة تحد من تهورها لكي لا تخرج عن السيطرة. لو وثقت الشركة بعقل الروبوت (المتعلم) وتهاونت في رسم حدوده ستواجه روبوت لا يمكن التنبؤ بتصرفاته مستقبلا واحتمالية خروجه عن السيطرة كبيرة جدا. المشكلة ان الروبوت اذا خرج عن السيطرة ربما يعتدي لفظيا على الناس او يعتدي على مبادئ الناس وقيمهم واديانهم ومجتمعاتهم (مثل ماحصل مع تاي). ولهذا، التجارب والابحاث تقول لابد تتم تغذية عقل الروبوت الذكي تغذية سليمة قبل إطلاقه، لابد للروبوت ان يعرف ويحترم حقوق الاخرين ولا يعتدي عليها.

وتغذية الروبوت تتم بطريقتين: الاولى برمجته بنظام مغلق يحتوي على (الصح والخطأ) في حياة الناس ويتصرف بناءً عليها، والثانية برمجته بنظام مفتوح يتعلم من البيئة ومن مخالطة الناس الصح والخطأ، لكن هذا خطير لانه ممكن يتعلم اشياء سيئة ويطبقها. لكن، هناك اشكاليات اخلاقية محل نقاش في الطريقة الاولى (تغذية نظام مغلق)، على اي اساس يتم تحديد الصح والخطأ؟ من يحددها؟ بناءً على اي ثقافة او دين تم اعتمادها؟ بمعنى آخر، من له الحق بتحديد ان هذا الفعل خاطئ او صحيح وعلى ماذا استند؟ ممكن فيه (فعل او قول) صحيح في ثقافة او منطقة ولكن بشع بثقافة اخرى. لذلك الشركات المنتجة للروبوتات الذكية (مستقبلا) سيواجهون اشكاليات بفهم ثقافات الشعوب وقوانين الدول وعادات المجتمعات وتعاليم الاديان.

في الحقيقة ان الحديث حول الاشكاليات القانونية والاخلاقية بتصنيع واستخدام الروبوتات الذكية طويل ومتشعب وحادثة (تاي) كانت مثال واقعي على بعض المخاوف.