بعض آلات وأنظمة الذكاء الاصطناعي مزودة بحساسات وأجهزة رؤية للتعرف على البيئة المحيطة لكي تعمل. لكن ماذا لو تم التلاعب بتلك الحساسات أو أجهزة الرؤية؟ ليس تخريب بل تلاعب بما تحس او ترى! وهنا تكمن المشكلة. وبالمثال يتضح المقال:

المثال الأول، فريق من الباحثين نجحوا بخداع نظام تيسلا للقيادة الذاتية وجعلوه يحرف السيارة للمسار الآخر (مسار السيارات بالاتجاه المعاكس).. تم ذلك بوضع ٣ ملصقات صغيرة على الطريق يقرأها نظام القيادة الذاتية انها علامات لانحراف السيارة. في هذا المثال عرف الباحثون ان نظام الرؤية بالسيارة يتعرف على عدة علامات ويقرأها ويترجمها على انها مؤشرات لانحراف السيارة او لبقائها على نفس المسار، ونجحوا بالتلاعب بما ترى السيارة.

وهنا مقطع يوضح التجربة

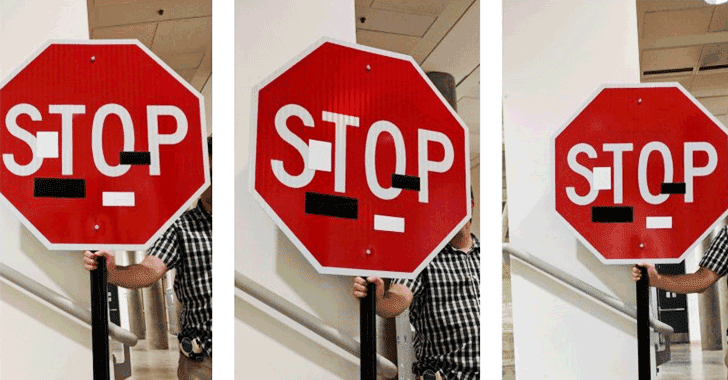

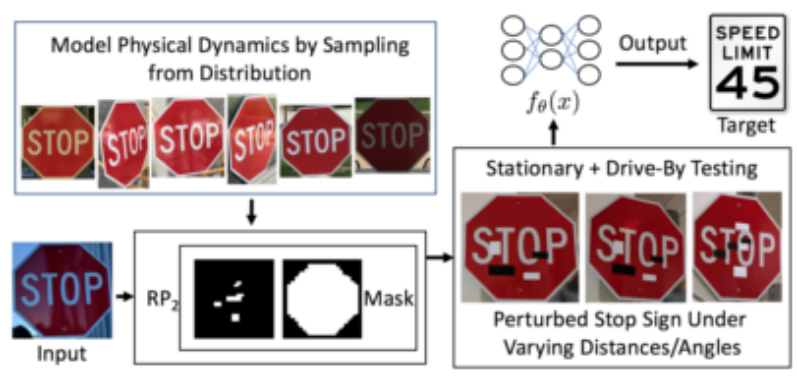

مثال آخر، تمكن باحثون من خداع نظام الرؤية في السيارات ذاتية القيادة بحيث جعلوه يقرأ لوحات “قف” وكأنها لوحات تحديد السرعة “٤٥ م/س” وذلك بوضع ملصقات على اللوحة تغير من شكلها لدى نظام الرؤية. تم التوصل لهذه النتيجة بواسطة الهندسة العكسية للنظام لدى المركبات.

مثال أخير، وهو أن بعض السائقين للسيارات التي فيها نظام قيادة ذاتية على الطرق السريعة تمكنوا من خداع النظام وابقائه يعمل رغم عدم امساكهم بالمقود او حتى جلوسهم بمقعد السائق وذلك بوضع جسم على المقود ليخدع النظام وكأن هناك يد تمسك به (علما أن نظام القيادة الذاتية الموجود حاليا ببعض السيارات يلزم السائق بوضع يديه طوال الوقت على المقود واذا احس النظام بخلاف ذلك فإنه يصدر اصوات تحذيريه ثم يعطل القيادة الذاتية ويوقف السيارة)