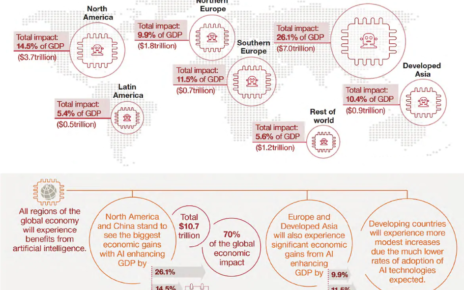

يخاف البعض من الروبوتات او الانظمة الذكية بسبب امكانية تمردها مستقبلا او سيطرتها على البشر، وهذا خوف نابع من افلام الخيال العلمي لكن الخوف الحقيقي هو ثقة البشر العمياء بها واعتمادهم عليها باتخاذ قرارات تمس حياتهم، وهذا له أمثلة حديثة. الثقة بنظام يتخذ قرار بطريقة مبهمة له تبعات خطيرة. الانظمة الذكية أحيانا تخطئ لانها انظمة تتعلم وربما تعليمها يكون فيه خطأ فينعكس هذا على قراراتها لذلك الثقة التامة بقرار نظام لا نعرف كيف تعلم ولا نعرف ماهية المعلومات التي اعتمد عليها هو خوف مبرر. الانظمة الذكية الان يعتمد عليها بالتوظيف، منح القروض، التمويل العقاري، العلاج، الأمن والحماية، وغيرها. وحينما يُرفض المتقدم على وظيفة، شركة تأمين، او بنك ربما لن يستطيع معرفة السبب الحقيقي للرفض لان النظام استبعده بناءً على البيانات التي تغذى عليها أثناء تعليمه. فالجهة المستخدمة للنظام وضعت ثقتها فيه باتخاذ القرارات والافراد المتلقين لتلك القرارات لا يعرفون اسباب الرفض او القبول لذلك يأتي هنا دور “الشفافية” في كيفية تعليم الانظمة، و”الشرح والتفسير” لقراراتها.

الشفافية في الانظمة والروبوتات الذكية مهمة:

للفرد لكي يثق فيها

للخبراء للتحقق من كفاءتها

لجهات التحقيق لمعرفة الاسباب (في حال وقوع حادث)

للجهات القضائية والمحامين لاستخدامها كأدلة

للتاجر لكي يستثمر فيها

للمجتمع ككل لكي لا يرفضها.

هناك الان عدة جهات وحكومات قائمة على بناء معايير لضبط عمل الانظمة الذكية للاستفادة القصوى منها وحماية المجتمع من اخطائها مثل مشروع IEEE P7001 – Transparency of Autonomous Systems

وهنا أمثلة لانظمة اتخذت قرارات خاطئة: هل الذكاء الاصطناعي دائما على حق؟